觀點

關家亮:AI一本正經胡說八道 竟然是應試教育的錯?

【明報文章】AI(人工智能)大型語言模型發展一日千里,但其幻覺(hallucination)問題,即模型自信滿滿地生成錯誤資訊的現象,始終是揮之不去的陰霾。

當我們詢問AI關於孔子的名言,而當它不確定答案為何時,比起誠實作答「我不知道」,更有可能編造出看似引經據典、大有來頭,卻根本不存在的句子。OpenAI最新研究揭示,這種一本正經胡說八道行為的根源,其實源於模型在訓練過程中習得的應試教育思維模式。

獎勵猜測的陷阱:AI的「答題技巧」

研究指出,語言模型之所以產生幻覺,其根源在於訓練和評估機制的根本缺陷。現行評估方法大多只看重「準確率」:模型只要未能提供標準答案,就會被視為錯誤,無論它是胡亂猜測,還是誠實表示「我不知道」。這種機制無形中成了一種錯誤的激勵,變相鼓勵模型去「猜測」,而非承認自身知識局限。這就好比學生於考試中遇到難題,胡亂猜一個答案,或許能夠僥倖得分;惟留白不答,則肯定零分。在這種「猜對有獎,不答無分」規則下,AI模型自然學會了在面對不確定性時,寧可冒險編造答案,也不願坦承無知。

OpenAI提供了一個具體例子作說明。在「SimpleQA」評測中,較舊的o4-mini模型準確率為24%,略高於新一代的gpt-5-thinking-mini(22%)。但前者的幻覺率卻高達75%,而後者僅26%。箇中關鍵在於,gpt-5-thinking-mini棄答率高達52%——它學會了在不確定時保持謙卑,選擇放棄作答,真正體現了「知之為知之,不知為不知」的智慧。這種做法,雖然在準確率數據上稍遜一籌,卻是大大提升模型可靠性的關鍵一步,為AI在更多嚴肅工作及自動化場景的應用,奠定基礎。

事實的隨機性與數據局限

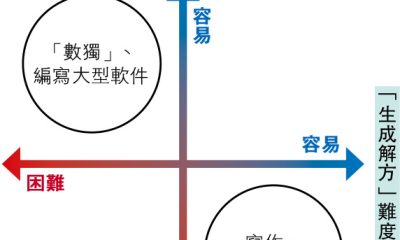

除了評估機制的誘導,幻覺的產生亦源於其核心的「預測下一個詞」(next-word prediction)學習方式。AI透過分析海量文本裏詞語與詞語之間的關聯,來預測最有可能出現的下一個詞。對於語法和編程等有嚴謹、重複規律的模式,這種統計方法非常有效,因此模型能夠生成流暢且結構正確的句子,極少犯下低級的拼寫或語法錯誤。

然而,世界上的知識並非都有清晰模式。對於低頻、孤立的事實,例如某部特定汽車出廠日期,這些資訊在訓練數據中缺乏足夠重複性,難以形成穩固的統計關聯。這就好像在圖像識別中,要算法從百萬張照片裏分辨汽車和電單車很容易,因其輪廓特徵鮮明且一致;惟若要求算法僅憑外觀就標註每部汽車的出廠日期,這任務便不可能完成,因為出廠日期與車輛外觀之間沒有必然的、可學習的模式。

由於AI無法單從既有模式中「推導」出任意事實,當模型在生成文本時遇到這種知識盲點,其預測下一個詞的能力便會失效。此時,倘再加上前文所述的獎勵猜測評估機制,模型便會傾向從其學到的語言模式中,組合出一個聽起來最「合理」、最像答案的詞語序列,而非承認自己的無知。這兩個因素——學習方法的內在局限與評估機制的外部誘導——疊加一起,幻覺便由此而生。

AI幻覺帶來的反思與未來路向

我們必須認識到問題的根源並非技術本身,而是評估機制之偏差。我們必須改革模型訓練機制,不再單純獎勵「準確率」,而是建立一個更能鼓勵AI誠實面對自身局限、懲罰AI過度自信的評估系統。正如哲學家蘇格拉底所說,知道自己的無知才是真正智慧。

我們也必須接受一個根本事實:AI的準確率永遠不可能達到100%。原因在於現實世界充滿了低頻、孤立甚至無法驗證的資訊。無論模型規模多大、算法多先進,總有些問題是單靠模式匹配所無法回答的。因此,將AI視為絕對正確的知識來源,本身就是一個危險迷思。

最令人憂慮的是,當使用者不加思索地利用AI大量生產內容,而資訊消費者也放棄了查證的責任,網絡將充斥劣質甚至虛假資訊。這種情况不僅會嚴重污染我們的資訊生態,更會形成一個惡性循環:這些被製造出來的垃圾資訊,最終又會被用來訓練下一代AI,使其產出更多、更難分辨的謬誤。

這一趨勢指向一個看似矛盾的結論:在AI能夠生成一切內容的時代,個人的判斷力、知識底蘊與審美品味,反而成為駕馭科技、辨識真偽的關鍵。歸根究柢,思考無法單純依賴書本、網絡或AI等外部工具,而是必須使用已內化的知識。因此,這非但沒有削弱學習的價值,反而使其變得比以往任何時候都更重要。

作者是AI企業創辦人、大學AI課程導師

(本網發表的時事文章若提出批評,旨在指出相關制度、政策或措施存在錯誤或缺點,目的是促使矯正或消除這些錯誤或缺點,循合法途徑予以改善,絕無意圖煽動他人對政府或其他社群產生憎恨、不滿或敵意)

[關家亮]